Revisitemos un concepto que ya hemos usado un par de veces hasta ahora...

Es una medida de la dispersión de un conjunto de datos respecto a su media. Se utiliza para caracterizar la incertidumbre de una única magnitud medida repetidamente.

Para \( n \) observaciones \( x_1, x_2, \ldots, x_n \) con media \( \bar{x} \), se calcula como:

\[ \sigma = \sqrt{\frac{1}{n-1} \sum_{i=1}^n (x_i - \bar{x})^2 } ~~~~~~~~ (5.1) \]Esta definición aparece en muchos otros conceptos de Estadística.

Es la desviación estándar estimada del resultado de una medición que depende de múltiples magnitudes. Combina las incertidumbres estándar de las magnitudes involucradas. Supongamos que la Potencia Eléctrica $P = VI$ con base en valores de diferencia de potencial eléctrico (también llamado $V$, voltaje) e intensidad de corriente ($I$) que medimos con nuestros instrumentos.

Consideremos antes el caso general: que nuestra medición indirecta es una función de $n$ variables $f(\bar{x})$ con $\bar{x} = (x_1, x_2, ..., x_n)$

\[ u_c = \sqrt{\sum_{i=1}^n \left( \frac{\partial f}{\partial x_i} \cdot u(x_i) \right)^2 + 2 \sum_{i=1}^n \sum_{j=i+1}^n \left( \frac{\partial f}{\partial x_i} \cdot \frac{\partial f}{\partial x_j} \cdot \text{Cov}(x_i, x_j) \right)} \]Esto parece una fórmula muy complicada, pero no te preocupes, pues para nuestros propósitos, debido a que las fuentes de error de los parámetros son casi siempre aleatorias, no existe correlación estadística entre los errores. Si no hay correlaciones (\( \text{Cov}(x_i, x_j) = 0 \)), la fórmula se simplifica a:

\[ u_c = \sqrt{\sum_{i=1}^n \left( \frac{\partial f}{\partial x_i} \cdot u(x_i) \right)^2 } \qquad (5.2) \]donde $\frac{\partial f}{\partial x_i}$ es la derivada parcial de la función con respecto a la $i$-ésima variable y $u(x_i)$ es la incertidumbre absoluta individual asociada al instrumento con el que se tomó su medición, es decir, en este caso la mitad de la mínima escala en ditribución rectangular.

Tanto la desviación estándar como la incertidumbre típicia combinada están relacionadas por su uso en la propagación de incertidumbres:

La desviación estándar describe la incertidumbre de un conjunto de mediciones individuales. La incertidumbre típica combinada extiende este concepto para incluir múltiples fuentes de incertidumbre, ponderadas por sus efectos en el resultado.

Básicamente, usaremos la incertidumbre típica combinada para cuando queramos calcular la incertidumbre asociada a una función de varias variables (medición indirecta), como una sustitución moderna a la suma lineal de errores máximos (sección opcional de la Lección 4).

En la fórmula de la incertidumbre típica combinada aparece el término de la correlación entre magnitudes $Cov(x_i,x_j)$, pero en un laboratorio de la vida real, tanto universitario como profesional, la gran mayoría de las veces ese coeficiente se toma como cero. La razón es que normalmente las variables que medimos provienen de instrumentos distintos, procedimientos separados o fuentes de error independientes.

El que un valor salga un poquito más grande o más chico no afecta sistemáticamente a otro valor medido. Por ejemplo, la lectura de calibrador con un vernier no “arrastra” ni “empuja” la lectura de un reloj, ni la temperatura del laboratorio. Todo está suficientemente desconectado como para que no haya relación estadística entre ellos. Por eso, en condiciones comunes de un laboratorio, donde usamos mediciones independientes y equipos separados, lo razonable (y recomendado por la GUM cuando no hay evidencia de lo contrario) es simplemente decir que el coeficiente de correlación vale $ 0$ , lo que simplifica la fórmula y refleja la realidad de la práctica experimental básica.

Caso: Queremos medir la potencia eléctrica \( P \) (unidades: watts o vatios [$W$]) usando:

La potencia se calcula como \( P = V \cdot I \).

1. Derivadas parciales:

\[ \frac{\partial P}{\partial V} = I, \quad \frac{\partial P}{\partial I} = V \]2. Incertidumbres absolutas individuales:

\[ u(V) = 0.5, \quad u(I) = 0.1 \]3. Incertidumbre típica combinada:

\[ u_c(P) = \sqrt{\left( I \cdot u(V) \right)^2 + \left( V \cdot u(I) \right)^2} \]Sustituyendo valores:

\[ u_c(P) = \sqrt{(2.0 \cdot 0.5)^2 + (100.0 \cdot 0.1)^2} = \sqrt{1.0 + 10.0} = \sqrt{11.0} \approx 3.32 \, \text{W} \]La incertidumbre típica combinada (\( 3.32 \, \text{W} \)) incluye los efectos de las incertidumbres en \( V \) e \( I \) combinadas según la propagación de incertidumbres.

La incertidumbre típica combinada relativa es la incertidumbre combinada de una función dividida entre la función misma, es decir:

\[ \frac{u_c(f)}{f} \]

ProductoSi tenemos una función $R = R(A,B) = A \cdot B$, tenemos que:

\[ \frac{u_c (R)}{R} = \sqrt{\left( \frac{u_A}{A}\right)^2 + \left( \frac{u_B}{B} \right)^2} ~~~~ (5.3)\]

CocienteSi tenemos una función $R = R(A,B) = \frac{A}{B}$, tenemos que:

\[ \frac{u_c (R)}{R} = \sqrt{\left( \frac{u_A}{A}\right)^2 + \left( \frac{u_B}{B} \right)^2} ~~~~(5.4); \]

que es idéntica a la incertidumbre combinda relativa del producto de $A$ y $B$.

Logaritmo naturalSi tenemos una función $R = \ln A$, tendremos que:

\[ \frac{u_c (R)}{R} = \frac{u_A}{A^2} ~~~~(5.5)\]

PotenciaSi tenemos una función $R = A^n$, tenemos que:

\[ \frac{u_c (R)}{R} = n \frac{u_A}{A} ~~~~ (5.5)\]

Ponemos a tu disposición una Calculadora de Incertidumbre Combinada. Sigue el pequeño manual de instrucciones aquí:

Según la manera de obtención de los datos, existen tres tipos de incertidumbre combinada. Las incertidumbres se clasifican de acuerdo con cómo se obtienen los datos y de qué tipo de información proceden. De esta forma podemos distinguir tres categorías principales: Tipo A, Tipo B y la incertidumbre expandida, que a veces se denota como $U$.

Se evalúa por métodos estadísticos, es decir, cuando se repite una medición varias veces en las mismas condiciones y los valores varían ligeramente. Proviene de la dispersión natural de los datos y se calcula con la desviación estándar de la media:

\[ u_A = \frac{s}{\sqrt{n}} \qquad (5.6), \qquad \sigma = \sqrt{\frac{\sum (x_i - \bar{x})^2}{n-1}} \qquad (5.7) \]Cuantas más veces se mida, menor será esta incertidumbre, porque el promedio se vuelve más estable.

Ejemplo: En la Lección 2 la utilizamos en el caso de: si medimos el tiempo de caída de una pelota cinco veces y obtenemos ligeras diferencias, esa variación se analiza estadísticamente para obtener \(u_A\).

Es la modificación de nuestro criterio original de la mitad de la mínima escala, y que ya conocemos como incertidumbre absulta, sin embargo, aquí forma parte de una sucesión de mediciones de datos experimentales. Se evalúa cuando no hay datos repetidos o cuando la información proviene de otras fuentes: manuales del fabricante, certificados de calibración, experiencia previa o resolución del instrumento. En este caso no se usa estadística experimental, sino un razonamiento basado en el conocimiento del instrumento.

Cuando se desconoce la probabilidad exacta dentro de un intervalo, la GUM recomienda suponer una distribución rectangular (uniforme):

\[ u_B = \frac{a/2}{\sqrt{3}} \quad = \frac{\text{mitad de la mínima escala}}{\sqrt{3}} \quad (5.8) \]Esto significa que el valor verdadero tiene la misma probabilidad de encontrarse en cualquier punto del rango ±a. El Tipo B refleja la incertidumbre instrumental o sistemática.

En la práctica, el resultado final de una medición suele estar afectado por ambos tipos de incertidumbre: la aleatoria (Tipo A) y la instrumental o sistemática (Tipo B). Para expresar la incertidumbre "total" del resultado final, se combinan ambas en suma en cuadratura:

\[ U = k \cdot \sqrt{u_A^2 + u_B^2} \qquad (5.9) \]Esta es la incertidumbre combinada.

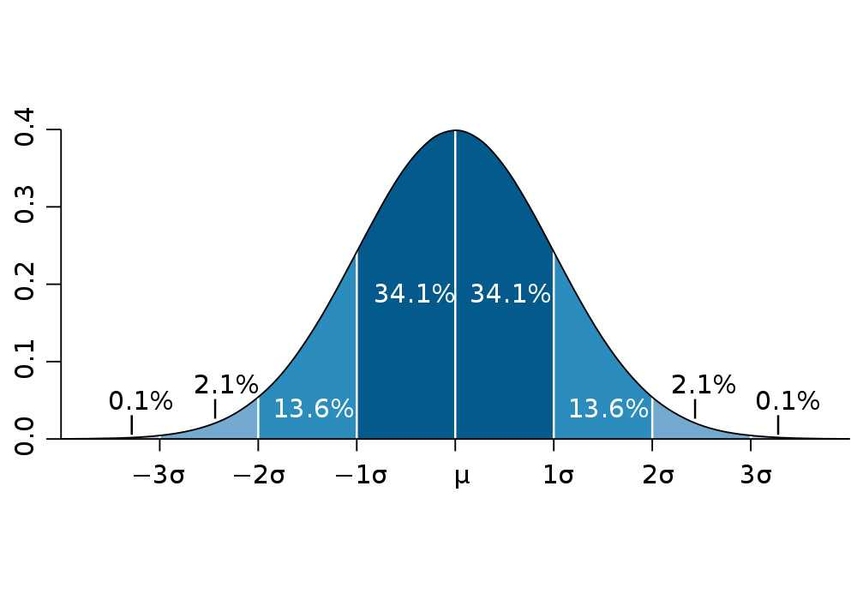

El factor de cobertura $k$ suele tomarse como $k = 2$ porque, cuando las fuentes de incertidumbre se combinan y el resultado se comporta como una distribución normal, multiplicar la desviación estándar por 2 y usarla como rango de incertidumbre alrededor del valor medio abarca cerca del 95% de los valores posibles. En un laboratorio universitario esto es suficiente para dar un intervalo razonable de confianza sin complicar el cálculo.

La distribución normal es una curva en forma de campana (también llamada Campana de Gauss) que describe cómo muchos datos se concentran alrededor de un valor central (media o promedio) y disminuyen hacia los extremos. En los laboratorios, los errores pequeños y aleatorios de diferentes fuentes suelen combinarse de tal manera que el resultado se ajusta bastante bien a la distribución normal.

\[ f(x) = \dfrac{1}{\sigma \sqrt{2\pi}} \, \exp\left( -\,\dfrac{(x - \mu)^2}{2\sigma^2} \right) ~~~~ (5.10) \] donde:

Para propósitos de la Campana de Gauss:

$u_c$ viene representando la desviación estándar ($\sigma$) de la distribución de todos los datos

analizados en el experimento después de combinar todas las contribuciones de incertidumbre y contemplando el resultado final como $\mu$,

y $k$ es un factor que expande esa desviación estándar para formar un intervalo de confianza del 95%.

Si te interesa saber más sobre la fascinante Ditribución Normal, te recomendamos: Freedman, D., Pisani, R., & Purves, R. (2007). Chapter 6: The Normal Curve. En Statistics (4th ed., pp. 127–158). W. W. Norton & Company.

Así, \(U\) delimita el intervalo dentro del cual es muy probable que se encuentre el valor verdadero. Esta, la Incertidumbre expandida, es la incertidumbre "final" que queremos obtener después de nuestros experimentos.

Sin embargo, en la mayoría de tus experimentos, para obetner la incertidumbre asociada al promedio experimental final, no usaremos la ecuación (5.9), sino una pequña modificación introduciendo algo que llamaraemos $I.C.M.$ (Incertidumbre Combinada de la Media).

En la práctica, no siempre repetimos una misma medición directa varias veces con el mismo instrumento. A veces, cada resultado proviene de un cálculo o medición independiente (por ejemplo, cada vez se usa un conjunto de datos diferente, o se calcula una magnitud derivada con sus propias incertidumbres combinadas). En esos casos, cada valor obtenido tiene su propia incertidumbre combinada, denotada por \(u_{c,i}\).

Supongamos que repetimos el experimento \(n\) veces y obtenemos los resultados: \[ x_1,~x_2,~x_3,~\ldots,~x_n \] cada uno acompañado por su incertidumbre combinada \(u_{c,1},~u_{c,2},~\ldots,~u_{c,n}\).

El promedio de estos resultados es: \[ \bar{x} = \frac{1}{n} \sum_{i=1}^{n} x_i \qquad (5.11) \]

Como la media es \(\bar{x} = \frac{1}{n} (x_1 + x_2 + \ldots + x_n)\), cada derivada parcial es \(\frac{\partial \bar{x}}{\partial x_i} = \frac{1}{n}\). Al sustituir en la ecuación (5.2), obtenemos:

\[ I.C.M. = \sqrt{\frac{1}{n^2} \sum_{i=1}^{n} u_{c,i}^2} \qquad (5.12) \] Con cada $u_{c,i}$ siendo la incertidumbre típica combinada del inicio de la lección. Esta ecuación nos da la incertidumbre combinada de la media cuando los resultados individuales ya tienen su propia incertidumbre combinada.Nota: La “I.C.M.” (Incertidumbre Combinada de la Media) es una nombre didáctico que fue adoptado en esta guía para representar la suma en cuadratura de las incertidumbres típicas combinadas de cada iteración. En la GUM y en Bell, Stephanie (NPL Guide No. 11) esta magnitud se describe simplemente como la incertidumbre estándar del promedio cuando cada valor posee su propia incertidumbre combinada.

| Tipo | Cómo se obtiene | Origen principal |

|---|---|---|

| A | Por estadística (repetir y calcular la dispersión) | Variación aleatoria de los datos |

| B | Por conocimiento del instrumento o calibración | Resolución, certificado o manual |

| Incertidumbre típica combinada $u_c$ |

Combinando las $u_B$ en cuadratura | Cada instrumento involucrado en la medición indirecta |

| I.C.M. | Combinando las \(u_c\) de cada medición | Promedio de resultados independientes |

| Expandida $U$ |

Combinando \(u_A\) y la $I.C.M.$ en cuadratura | Todas las fuentes de incertidumbre |

Una vez que se obtiene el valor final de una magnitud experimental y su incertidumbre expandida \(U\), es posible comparar el resultado con un valor de referencia.

La GUM recomienda evaluar si el resultado experimental y el valor de referencia son concordantes usando el siguiente criterio:

\[ |v_{\text{promedio}} - v_{\text{referencia}}| < U \qquad (5.13) \]donde:

Si la diferencia entre el valor experimental y el valor de referencia es menor que la incertidumbre expandida, los resultados se consideran concordantes o compatibles dentro del margen de incertidumbre.

Por el contrario, si:

\[ |v_{\text{promedio}} - v_{\text{referencia}}| > U, \]entonces la medición y el valor de referencia se consideran no concordantes, lo que sugiere revisar posibles fuentes de error sistemático, condiciones de medición, o la calibración del instrumento.

Nota del autor: no porque seas un estudiante de primeros semestres desprecies siempre tu resultados ante los valores de referencia. Puede que tú estés haciendo las cosas bien, y sea el valor de referencia el qeu no es exacto respecto al valor real.

Un experimento para medir la aceleración de la gravedad da: \[ g_{\text{exp}} = (9.75 \pm 0.10)~\text{m/s}^2. \] El valor nominal aceptado localmente es: \[ g_{\text{ref}} = 9.81~\text{m/s}^2 \]

La diferencia es: \[ |9.75 - 9.81| = 0.06 < U = 0.10 \] Por tanto, el resultado es concordante con el valor teórico.

Esto significa que, considerando la incertidumbre del experimento, no hay evidencia suficiente para afirmar que el resultado difiere del valor de referencia. Es decir, la medición y el valor teórico son compatibles dentro del nivel de confianza elegido.

¡Excelente! Ahora veremos dos experimentos ejemplo para que observes el manejo real de datos experimentales paso a paso.